API监控精准整合 - 提升数据处理效率的方法

理解API监控的必要性

在当今的数字时代,API(应用程序接口)是不同软件和服务之间进行交互的桥梁。通过API,应用程序能够调用其他软件的功能和数据。因此,监控API的性能和稳定性尤为重要。准确的API监控不仅可以提高用户体验,还有助于及时发现和解决潜在的问题。

数据来源的多样性

API监控的准确性依赖于多种数据源。这些数据源可能包括服务器日志、用户反馈、第三方监控服务、内部监控工具等。每种数据源都有其独特的价值,但同时也带来了整合和处理的挑战。

主要的数据源

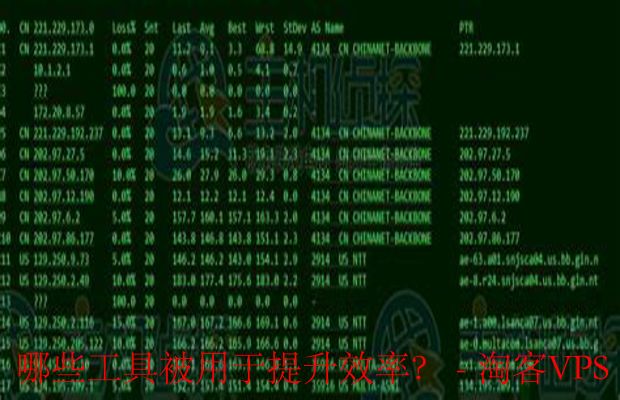

- 服务器性能指标:包括响应时间、错误率、吞吐量等。

- 用户行为数据:用户在使用API时的行为分析。

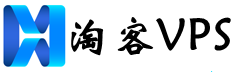

- 外部监控工具:通过第三方服务获取API的健康状态和性能指标。

- 应用程序日志:记录API调用的详细信息和错误信息。

数据整合的步骤

为了提供准确的API监控结果,必须对来自不同信息源的数据进行有效整合。以下是几个关键步骤:

1. 数据收集

首先,确保从各个数据源收集所需的数据。这可能涉及使用API抓取、数据库查询、日志文件读取等方式。数据收集的完整性直接影响到后续分析的准确性。

2. 数据清洗

收集到的数据往往存在冗余、缺失或不一致的情况。数据清洗这一过程至关重要。使用数据清洗工具或编写脚本,剔除无用信息、填补缺失值、统一数据格式,以确保数据的质量。

3. 数据整合

数据整合的关键在于将不同来源的数据合并成一个统一的视图。这可以通过数据仓库、ETL(提取、转换、加载)流程或使用适当的数据集成工具来完成。选择一种合适的方法来整合数据,以便于后续的分析和监控。

4. 数据分析

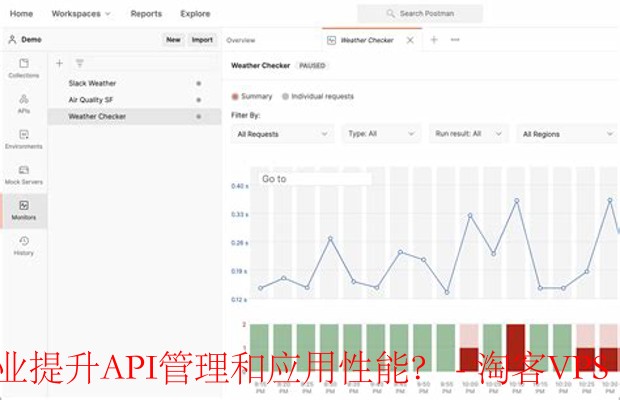

整合后的数据需要进行深入分析,以提取有价值的信息。使用统计分析、图表可视化或机器学习模型来识别趋势、异常和潜在问题。定期分析数据能够帮助识别API性能的变化。

5. 监控和报警

在分析数据的基础上,建立监控机制,以实时跟踪API的性能。设置合适的阈值,当数据超出预期范围时,自动触发报警,以便快速响应问题。

使用工具提升效率

在整合和监控API数据的过程中,借助一些工具可以大幅提升效率。例如,使用数据可视化工具(如Grafana、Tableau)来展示监控结果,利用数据集成平台(如Apache NiFi、Talend)来自动化数据流动。这样,不仅可以节省时间,还有助于减少人为错误。

总结

整合来自不同信息源的数据以提供准确的API监控结果是一项复杂但必要的任务。通过系统化的数据收集、清洗、整合和分析过程,以及合理使用工具,你可以大大提高API监控的效率和准确性。只有这样,才能在竞争激烈的市场中保持优势,确保用户的满意度。